https://programmerk.tistory.com/110

Improving Language Understandingby Generative Pre-Training 리뷰

배경 : 기존 지도학습 방식은 라벨링, 어노테이션등 노동력이 필요하고, 이에 따른 적용 한계가 존재한다. 이러한 한계점 (시간적, 비용적) 극복하기 위하여 비지도 학습 방안을 고려하기 시작함

programmerk.tistory.com

배경

아직도 지도학습 방법이 많이 사용되고, 이로 인해 데이터의 분포가 잘못될 경우 성능에 취약하다는 단점이 존재한다.

이러한 방식은 특정 분야 ( narrow experts ) 에서 잘 동작한다. 그 이유로는 단일 도메인 데이터셋과 단일 작업 학습이(single task training on single domain datasets) 일반화 부족의 주요 원인이라 의심됨. 이에 다양한 도메인과 학습으로 일반적인 똑똑한 전문가 모델만드는 부분으로 나아가고자 한다. 최근 가장 좋은 모델은 사전 학습한 모델에 파인튜닝을 하는 방식이 가장 성능이 좋다. 이 논문에서는 오직 대규모 데이터 기반의 사전학습만으로 다양한 작업에서 높은 일반화 능력을 갖춘 모델을 만들 수 있음 제시

접근 방식

이전 방식들은 뉴스기사, 위키디피아, 소설 같은 단일 도메인 훈련하였음

반대로 Common Crawling 를을 데이터 셋으로 사용할 것 ( 다만 데이터 품질의 문제가 존재함 )

Training dataset :

- Common Crawling 문제점 :

- whose content are mostly unintelligible : 이해하기 어려운 내용

- 중복된 내용

- 저품질 데이터, 노이즈

- Common Crawling 해결 방안:

- 새로운 방안의 크롤링 제시

- Reddit 에서 at least 3 karma 데이터 대상

- 총 4500만개의 링크에서 수집된 휴리스틱 기반 정리된 800만개 의 문서 ( 40GB )

- 중복 제거

- 2017년 12월 이후 데이터 제거

- 위키디피아 데이터 제거

Input Representation

이전의 Unicode 를 UTF-8 byte 시퀀스 방식으로 하는것은 비 효율적임, 경쟁력이 부족함

따라서 Byte Pair Enconding(BPE) 방식을 사용하여 적은수의 토큰을 통해 효율처리 지원

Model

Transformer 신경망 구조를 기반

- self-attention 후 한 번 더 정규화 layer 추가

- Residual connection 가중치를 layer 수에 맞게 조절하여 학습 안정성을 개선

- 토큰수 50,257 증가

- 컨텍스트 크기 512->1024 증가

- 배치 크기 증가

실험

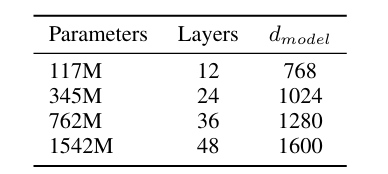

4개의 모델 준비 ( 각각의 파라미터 기준 )

- 117M : 초기 GPT 수준

- 345M : BERT 수준

- 762M : BERT 이상 수준

- 1542M : GPT2

실험목적

언어 모델이 zero-shot 환경에서 모델이 얼마나 잘 적응하는 평가

- PPL(perplexity)은 낮을수록 좋음

- ACC(accuracy)는 높을수록 좋음

perplexity : 언어 모델이 다음에 올 단어를 얼마나 잘 예측하는지를 수치로 나타내는 지표

파라미터 크기를 키운 GPT-2 계열 모델이 기존 최신 시스템(SOTA)보다 여러 벤치마크에서 더 낮은 perplexity와 더 높은 정확도를 달성할 수 있음을 보여준다.

Discussion

- GPT-2는 독해, 질의응답에서 지도 학습 모델과 경쟁 간으 수준

- 그러나 요약,복잡한 작업에서는 아직 성능이 낮음

- GPT-2 성능은 모델 크기와 학습 데이터 양에 따라 개선가능

- 다만, 실용적 사용을 위해서는 여전히 파인튜닝이 필요하다는 한계도 명확히 존재