이전 구성도

이슈 :

1. 뉴스 정보 : mcp 서버에서 받아온 api 호출값이 제목, 본문 요약, 원본 링크 URL 정보로 풍부하지 못함

2. 원본 링크 : 다양한 뉴스 채널별로 html 구조가 달라 파싱의 어려움

3. 답변 생성 시간 : 카카오톡에서 response 시간 5초 이상시 timeout 됨

4. 답변 품질 : 뉴스 정보의 품질 하락으로 인하여 모델에서 생성되는 답변 품질 또한 하락

5. 단방향 프로세스 : 모든 질문에 대해 naver 뉴스를 검색하여 처리하려함

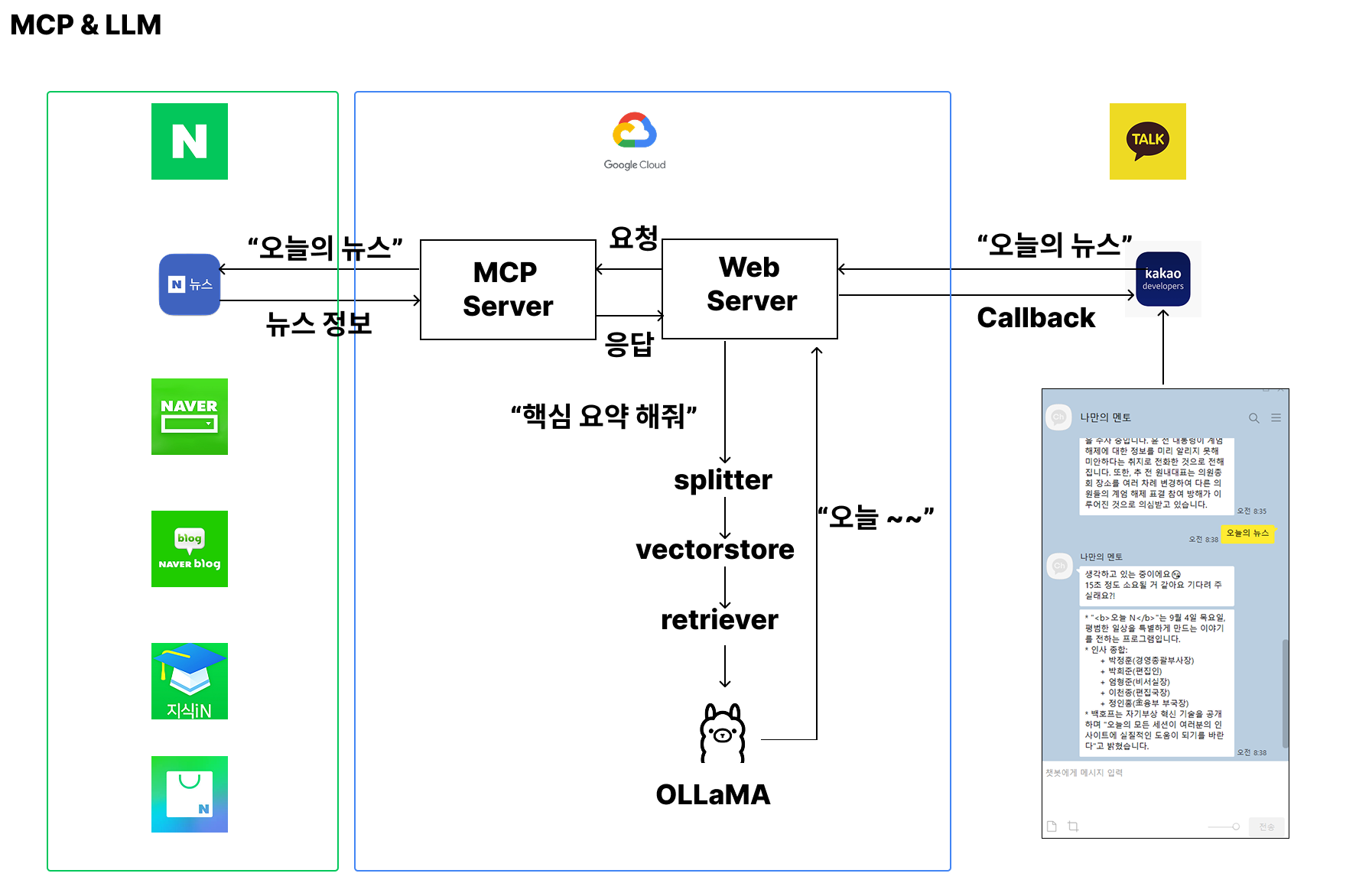

개선 된 구성도

적용 내용

1. 뉴스 정보 : 네이버에 등록된 원본 뉴스에 대해서 파싱 추가

2. 원본 링크 : langchain WebBaseLoader 활용하여 파싱 예정

3. 답변 생성 시간 : 카카오톡에 callback 가능하도록 요청 ( 1분 안에 callback 가능 )

4. 답변 품질 : 앙상블, 멀티 쿼리, 리랭크, 리오더 기법 활용,

- gpt-4.1-mini 와 ollama-ko-0710 모델 비교 실험

- gpt-4.1-mini 는 유료, 답변 속도 매우 빠름, 답변 시간 약 10 초이내

- ollama-ko-0710 무료, 답변 속도 비교적 느림, 답변 시간 gpt + 10 ~20초 필요

- 답변 품질, 자연스러움, 문맥, 정확도 면에서 gpt 가 더 우수하나 ollama도 성능도 상승

- 두 모델의 답변 품질을 perplexity 로 평가시 크게 점수 차이안남 (예시=> 8.4 vs 8.0 )

5. 단방향 프로세스 : 모든 질문에 대해 naver 뉴스를 검색하여 처리하려함

굳이 유료 모델을 써야하는가에 대한 의문 존재....

남은 과제

1. 원본 링크 : 다양한 유형의 뉴스 정보 파싱 로직 추가

2. 이전 대화 내용 메모리 저장

3. RAGAS 활용 성능평가

4. 단방향 프로세스 개선

5. pdf 등 파일 활용

6. 멀티 모달